Gaze-Conditioned Grasp Synthesis via 2D Segmentation and 3D Reconstruction

Abstract

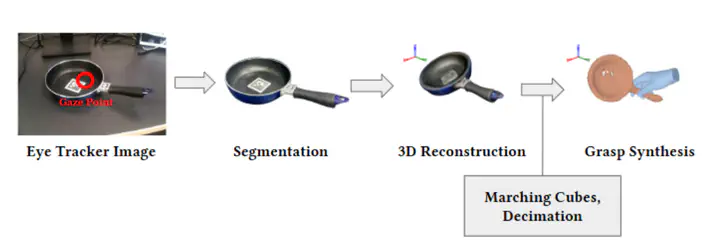

본 연구는 아이트래커를 통해 추출한 1인칭 시점 이미지(egocentric image)와 시선 좌표 정보(gaze point)를 조건으로 하여 사용자가 응시한 물체를 인식하고 3D로 복원한 뒤, 해당 객체에 대한 자연스러운 파지 자세 생성(grasp synthesis)을 수행하는 엔드투엔드 파이프라인을 제안한다. 기존 연구는 시선 정보를 로봇의 파지 대상 선택이나 행동 분류에 활용하는 데 그쳤으며, 이를 3D 복원 및 인간 손 기반 파지 생성까지 연결한 사례는 드물다. 본 연구는 시선 기반 2D 분할–3D 복원–파지 생성 단계를 하나의 흐름으로 통합하였으며, 사용자 평가에서 객체 선택 정확도, 분할 품질, 단계 간 물체 일관성에서 높은 타당성을 보였다. 이를 통해 시선 기반 조작 시스템의 새로운 가능성을 제시한다.

Publication

Korean Institute of Information Scientists and Engineers